大まかな動きの情報のみで手話単語を高精度に認識できなかった

大阪公立大学は12月19日、米国の手話単語のAIを用いた認識手法について、従来の認識手法である上半身の大まかな動きの情報に、手や顔の表情などの局所情報と、手と体の位置関係を表す骨格情報を加えたと発表した。この研究は、同大大学院情報学研究科の井上勝文准教授、岩村雅一准教授、同大研究推進機構協創研究センター文書解析・知識科学研究所のPartha Pratim Roy客員研究員らの研究グループによるもの。研究成果は、「IEEE Access」に掲載されている。

画像はリリースより

(詳細は▼関連リンクからご確認ください)

聴覚障害者とコミュニケーションを取る方法の一つとして、手話がある。手話は、手や腕の動き、表情、手の形状、手と体の位置関係などの情報を組み合わせることで表現される単語(手話単語)を、さらに組み合わせることで会話を実現する視覚言語の一種である。世界各国独自の手話が体系化されており、どの国の手話も数千個以上の手話単語が存在している。習得すべき手話単語の多さが、手話の習得を難しくしている要因の一つと考えられており、手話単語を表現する話者を撮影した動画から、AIを用いて手話単語を自動で認識する研究が盛んに行われている。

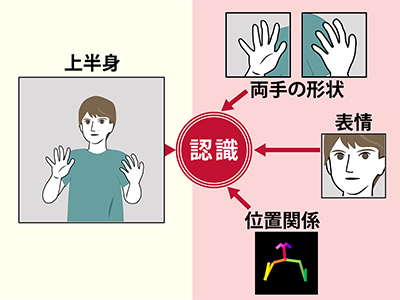

これまでの手話単語認識に関する研究では、手話を「お辞儀をする」「手を振る」などの一般的な動作の一種と見なし、話者の大まかな動きの情報を捉える手法を用いてきた。しかし実際には、手の形の細かな違いや、手と体の位置関係の違いによって意味が異なるため、大まかな動きの情報だけでは手話単語を高精度に認識できないという問題があった。

手や顔の表情などの局所情報+人物の骨格情報を追加

今回の研究では、別の研究グループによる顔認識研究において、顔全体の情報に加えて目や口などの局所領域の情報も組み合わせることにより、顔認識精度が向上したという知見を参考にした。研究グループは、手話を表現している話者の上半身の大まかな動きの情報に、手や顔の表情などの局所情報と、手と体の位置関係として人物の骨格情報を加えることで、手話単語の認識精度を向上できるのではないかと考えた。これを実現するために、上半身と局所領域の情報には深層学習モデルI3D、骨格情報にはST-GCNを用いて、情報ごとに手話単語を認識した結果を統合した。

従来手法より認識精度を10~15%向上

米国の手話単語認識データセットで検証した結果、話者の大まかな動きの情報のみを用いた従来手法と比較して、認識精度を10~15%向上できることが判明した。

手話翻訳の構築と精度向上などの課題解決を目指す

今回の研究によって、手話単語認識の精度を高めることができた。また今回提案した手法は、どの国の手話にも適用できるため、さまざまな国で聴覚障害者の人々とのコミュニケーション活性化につながることが期待できるとしている。今後は手話単語認識のさらなる精度向上や、同手法を用いた手話翻訳の構築と精度向上などの課題解決を目指す、と研究グループは述べている。

▼関連リンク

・大阪公立大学 プレスリリース